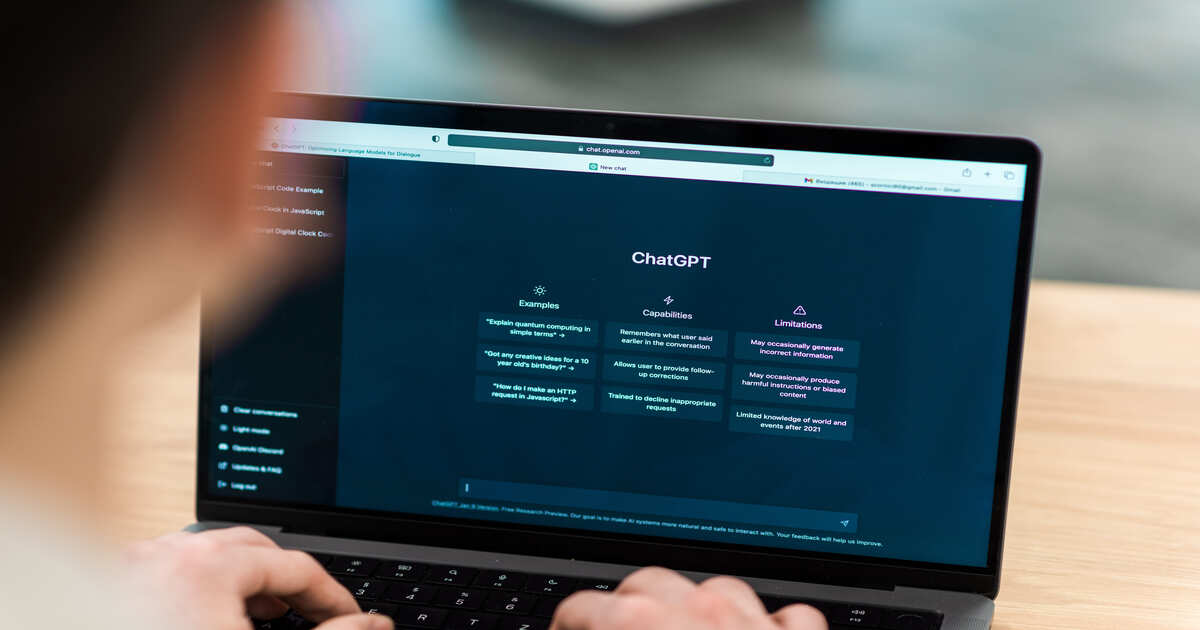

OpenAI’nin ChatGPT’si aracılığıyla sızdırılan konuşmalara ilişkin raporların ardından üretken yapay zeka araçlarının güvenliği ve gizliliğine ilişkin endişeler arttı. Olay, şirketlerin güvenlik önlemleri oluşturma çabalarına rağmen yapay zeka sistemlerindeki güvenlik açıkları hakkında soruları gündeme getirdi. Görünüşe göre kullanıcı adları ve şifreler de dahil olmak üzere hassas veriler oturumlar sırasında ilgisiz kullanıcılara sızdırıldı.

Sızıntıların başka bir kullanıcının teklif ve sunumlarının ayrıntılarını içermesi bekleniyor; bu da OpenAI’nin gizlilik politikalarının büyük bir ihlalidir. Kullanıcı şikayetine göre olay, güçlü şifrelere ve güvenlik önlemlerine rağmen meydana geldi.

OpenAI’ye göre veri sızıntısı, bir bilgisayar korsanının güvenliği ihlal edilmiş hesaplara yaptığı saldırıdan kaynaklanıyor ve konuşmanın kullanıcının gerçek konumu, ABD’deki Brooklyn yerine Sri Lanka’dan kaynaklandığı anlaşılıyor. Mart 2023’tede, kullanıcı ödeme verilerini sızdıran bir ChatGPT hatası tespit edilmişti.

Başka bir örnekte, ChatGPT yanlışlıkla Samsung’a ait şirket sırlarını sızdırdı ve bu da aracın dahili olarak yasaklanmasına yol açtı. OpenAI, Google ve Anthropic gibi önde gelen yapay zeka şirketlerinin tıpkı Hackdra’nın UlgenAI’si gibi bu tür riskleri önlemek için dikkatli güvenlik duruşlarına ve belirli önlemlere odaklanması gerekiyor.